-

Bidirectional-LSTM-CRF 논문 사전 용어 리스트<DL> 2024. 2. 29. 04:24728x90

- Sequence Tagging : 입력 시퀀스(문장 또는 문서)의 각 요소(단어, 토큰, 또는 문자)에 대해 레이블 또는 태그를 할당

- Sequence Data : 말 그대로 순서(sequence)가 있는 데이터

예시) 시계열 데이터, 텍스트 데이터

특징) 각 시퀀스 원소들은 특정 순서를 가져 독립적이지 않다. - Tagging : 텍스트에서 각 단어나 토큰에 레이블을 할당(https://wikidocs.net/24682)

- 품사 태깅(POS, Part-of-Speech Tagging) : 각 단어가 명사, 동사, 형용사 등의 품사 중 어떤 품사를 가지는지를 분류

ex) "The cat is sleeping."에서 "cat"은 명사(NN), "is"는 동사(VB), "sleeping"은 형용사(JJ)로 태깅 - 개체명 인식(NER, Named Entity Recoginizer) : 문장에서 사람, 장소, 단체, 날짜 등의 개체를 식별

ex) "Steve Jobs founded Apple in 1976."에서 "Steve Jobs"는 PERSON, "Apple"은 ORGANIZATION으로 태깅 - 구(chunking) : 문장을 단어의 그룹(청크)으로 나누고, 각 청크에 레이블을 할당(https://9566.tistory.com/552)

ex)"[The quick brown fox] [jumps] [over] [the lazy dog]." 각 청크는 대괄호로 묶여있으며, 명사구(NP), 동사(V), 전치사구(PP) 등의 레이블이 부여 - 의존성 구문 분석(Dependency Parsing): 각 단어 간의 문법적인 의존 관계를 태깅

ex) "The cat is sleeping on the mat."에서 "cat"은 "sleeping"에 의존(DOBJ), "sleeping"은 "is"에 의존(COMP) 등으로 태깅

- 품사 태깅(POS, Part-of-Speech Tagging) : 각 단어가 명사, 동사, 형용사 등의 품사 중 어떤 품사를 가지는지를 분류

- 전형적인 NLP(자연어 처리) 작업 중 하나

- Sequence Data : 말 그대로 순서(sequence)가 있는 데이터

- NLP benchmark sequence tagging data sets: 자연어 처리 모델의 성능을 비교 평가하기 위해 사용되는 표준 데이터셋

- 벤치마크는 컴퓨팅에서 특정 오브젝트에 대해 일반적으로 수많은 표준 테스트와 시도를 수행함으로써 오브젝트의 상대적인 성능 측정을 목적으로 컴퓨터 프로그램을 실행하는 행위 ex) 핸드폰 기종간 GeekBench Single Core 비교

- sentence level tag information thanks to a CRF layer(https://wikidocs.net/147234)

- sentence level tag information : 시퀀스 태깅 작업에서 문장 전체의 구조나 의미를 나타내는 정보를 의미(문장의 의도나 주제, 문장 구조, 문장의 형식적 특성)

- CRF(Conditional Random Fields) layer : 모델이 생성한 시퀀스 레이블(예: 각 단어의 품사 태그)을 조정하여 문장 전체의 일관성을 높이는 역할을 합니다. 이를 통해 문장 수준의 태그 정보를 사용할 수 있게 됩니다. CRF 층을 추가하면 모델은 예측 개체명, 다시 말해 레이블 사이의 의존성을 고려할 수 있습니다.

ex) "The cat is sleeping on the mat"이라는 문장에서 "cat" 다음에 오는 "is"는 동사(VB)일 가능성이 높습니다. "is" 다음에 오는 "sleeping" 역시 동사일 가능성이 높고, "on" 다음에 오는 "the"는 전치사(IN)일 가능성이 높습니다. 이런 문장 내 단어 간의 일관된 관계를 고려하여 모델이 레이블을 예측하는데 도움

- Robust : 다양한 조건에서도 일관된 성능을 유지, 노이즈가 많거나 다양한 유형의 데이터셋에서도 잘 동작하여 신뢰성 있는 결과를 제공

- Less dependence on word embedding : 워드 임베딩에 대한 의존성을 줄인다 -> 단어 수준이 아닌 문자, 하위단어, 문맥 등 모델이 더 많은 정보를 학습하도록 한다.

- 워드 임베딩 : 단어를 밀집표현(사용자가 벡터의 차원(크기)을 맞춰 사용, 벡터값도 0,1이 아닌 실수값)한 것 (https://9566.tistory.com/549)

- Down streaming applications : tagger의 결과를 활용하여 다른 새로운 작업을 하는 것

- "Bob works at Google."이라는 문장에서 "Google"이 ORGANIZATION으로 인식되었을 때, 이 정보를 활용하여 구글에 관한 정보를 검색하거나 구글에 대한 뉴스를 찾는 등의 작업을 수행

- 개체명 인식기(Named Entity Recognizer) : 태깅된 결과를 사용하여 제품 정보를 식별하여 광고를 활성화할 수 있습니다.

ex) 사용자 검색 쿼리에서 "iPhone X"라는 제품 이름을 인식하면, 이를 통해 해당 제품에 대한 광고를 트리거할 수 있습니다. - 검색 엔진(Search Engine)은 태그 정보를 사용하여 관련 웹 페이지를 찾을 수 있습니다.

ex) 사용자가 "최신 기술 트렌드"라는 검색어를 입력하면, 개체명 인식기가 "기술"이라는 개체를 인식하고, 검색 엔진은 이를 기반으로 관련된 기술 블로그나 뉴스 기사를 검색하여 사용자에게 제공할 수 있습니다. - Down streaming task : 전이학습을 통해 pretrained-model로 원하는 model을 만들고자 한 것(https://chan-lab.tistory.com/31)

- Linear statistical models

- HMM(Hidden Markov Models)

- HEMMs(Maximum entropy Markov Models)

- CRF(Conditional Random Fields)

- 위 순서대로 발전하였고 CRF는 HMM에 비해 복잡한 패턴과 문맥을 고려하여 더 좋은 성능을 보인다.

- Long distance feature : 과거 시간 단계에서 발생한 정보를 현재 시간 단계에서 사용, 모델이 문장이나 음성 데이터의 긴 의존성을 파악하고 이를 반영하여 예측을 수행

- Feedforward network(순방향 신경망) : 가장 기본이 되는 신경망 구조(하기 사진)

- Feedforward(순방향) 구조: 입력층에서 출력층으로 데이터가 한 방향으로만 흐르는 구조를 가집니다. 즉, 각 층의 출력은 그 다음 층의 입력이 되어 학습이 진행됩니다.

- Backpropagation through time(BPTT) : 시퀀스 데이터의 각 시간 단계마다의 오차를 역방향으로 전파하여 가중치를 조정

- Backpropagation : feedforward network(순방향 신경망)에서 사용

- Backpropagation through time(BPTT) : RNN(순환 신경망), LSTM 등에서 사용

- Beam-like decoding : 기계 번역 및 자연어 처리 분야에서 사용되는 디코딩 방법 중 하나입니다. 여러 후보 문장을 생성하고, 각 후보 문장에 점수를 매기는 과정을 반복하면서 최적의 문장을 선택하는 방식입니다.(하기사진) -> maximum entropy classifer, MEMMs 모델이 이용

- Greedy Decoding : 단순하게 해당 시점에서 가장 확률이 높은 후보를 선택

- Beam search : Greedy Decoding을 어느정도 극복하기 위해 사용, 빔서치에서 고려하는 모든 확률은 누적 확률, 유망한 빔의 개수만큼 (이하 K) 골라서 진행(https://blog.naver.com/sooftware/221809101199)

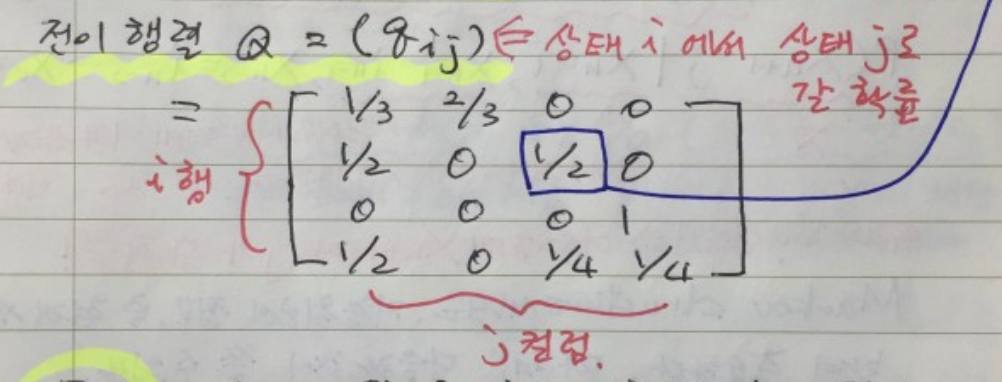

- state transition matrix : 각 태그 상태 사이의 전이 확률을 나타내는 매개변수

- 전이 행렬 Qij : 상태 i에서 상태 j로 갈 확률(하기사진)

- generic SGD forward and backward training procedure : 모델 학습 과정에서 순방향,역방향 SGD 손실함수를 사용

- SGD(Stochastic=Random Gradient Descent) : Loss Function(최적의 가중치값을 찾기 위해 사용)을 계산할 때, 전체 데이터(Batch) 대신 일부 데이터의 모음(Mini-Batch)를 사용하여 Loss Function을 계산한다. https://mangkyu.tistory.com/62

- GD(Gradient Descent = 경사하강법) : https://www.youtube.com/watch?v=c7NURwHmM5k

- state transition edges

- edge : 그래프 이론에서 사용되는 단어로, 그래프 노드 간을 연결하는 선을 의미

- BIO2(Begin, Inside, Outside, Other) annotation standard

- B (Begin): 개체명의 시작을 나타냅니다

- I (Inside): 개체명의 내부를 나타냅니다.

- O (Outside): 개체명이 아닌 토큰을 나타냅니다.

- Other: 추가적인 레이블로, 개체명이 아니거나 특정한 태깅이 필요하지 않은 경우에 사용됩니다.

- Senna Embedding : NLP Software 중 하나, 단어를 밀집 벡터로 표현하는 임베딩 기술 > 단어 간의 의미적 유사성을 파악하는 데 사용

- Gazetteer features : 사전 종류 중 하나로 지리적 장소, 기관명, 인명 등과 같은 명명된 개체를 나열한 사전

- N-gram : SLM(Statistical Language Model) 의 일종으로, 이전에 등장한 모든 단어를 고려하지 않고, 일부 n 개의 단어만 고려하는 방식

- Uni-gram : "apple", "banana", "orange"와 같은 개별 단어를 나타냅니다.

- Bi-gram : "apple pie", "banana split", "orange juice"와 같은 두 개의 단어 조합을 나타냅니다.

- Tri-gram : "eat an apple", "peel a banana", "drink orange juice"와 같은 세 개의 단어 조합을 나타냅니다.

- Feature Hashing technique

- Feature collision

- to initialize word embedding: Random and Senna : 랜덤임베딩, Senna 임베딩

- Lexicons : 사전, 어휘집

- baselines : 특정 작업이나 문제에 대한 기본적인 비교 대상이나 기준을 의미. LSTM, BI-LSTM, CRF를 기준으로 사용하여 다른 모델들의 성능을 비교할 것임. 이 모델들은 해당 작업에 대한 기본적인 모델이며, 다른 모델들과의 성능 비교를 위한 출발점으로 사용됩니다. 따라서 이러한 모델들을 "baselines"로 간주하고, 다른 모델들과의 비교를 통해 해당 작업에 대한 효과적인 모델을 발견하고자 합니다.

========================================================================================

9.

11

12

728x90

728x90'<DL>' 카테고리의 다른 글

Bidirectional LSTM-CRF Models for Sequence Tagging 정리 (0) 2024.03.09 Bidirectional-LSTM-CRF 논문 번역 (1) 2024.02.29 청크 태깅 레이블 (0) 2024.02.28 cbow (0) 2024.02.26 워드 임베딩, cbow (1) 2024.02.25 - Sequence Tagging : 입력 시퀀스(문장 또는 문서)의 각 요소(단어, 토큰, 또는 문자)에 대해 레이블 또는 태그를 할당